あなたの選択した答えは強調表示されています。

問題1 |

ある企業がセキュリティレビュー中に、AWS Glue ジョブの脆弱性を特定しました。同社は、Amazon Redshift クラスターにアクセスするための認証情報がジョブスクリプトにハードコードされていることを発見しました。

データエンジニアは、AWS Glue ジョブのセキュリティ脆弱性を修正する必要があります。ソリューションは認証情報を安全に保存する必要があります。

これらの要件を満たす最適な手順の組み合わせを選択してください。(2 つ選択)

AWS Secrets Manager に認証情報を保存します。 | |

AWS Glue ジョブの IAM ロールに、保存された認証情報へのアクセスを付与します。 | |

AWS Glue ジョブを使用して、Amazon S3 バケット内の設定ファイルから認証情報にアクセスします。 | |

Amazon S3 バケットにある設定ファイルに認証情報を保存します。 | |

AWS Glue のジョブパラメータに認証情報を保存します。 |

問題 1 の説明および補足

AWS Secrets Manager への接続認証情報の保存

問題2 |

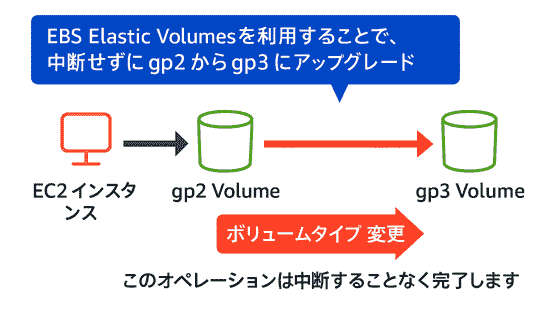

ある企業は、Amazon Elastic Block Store (Amazon EBS) の汎用 SSD ストレージを gp2 から gp3 にアップグレードする計画を立てています。同社は、アップグレードされたストレージへの移行中に、データ損失の原因となる Amazon EC2 インスタンスの中断を防ぎたいと考えています。

運用上のオーバーヘッドを最小限に抑えながら、これらの要件を満たすソリューションを選択してください。

gp2 ボリュームのスナップショットを作成します。スナップショットから新しい gp3 ボリュームを作成します。新しい gp3 ボリュームを EC2 インスタンスにアタッチします。 | |

新しい gp3 ボリュームを作成します。データを新しい gp3 ボリュームに徐々に転送します。転送が完了したら、新しい gp3 ボリュームを EC2 インスタンスにマウントして、gp2 ボリュームを置き換えます。 | |

AWS DataSync を使用して、新しい gp3 ボリュームを作成します。元の gp2 ボリュームから新しい gp3 ボリュームにデータを転送します。 | |

既存の gp2 ボリュームのボリュームタイプを gp3 に変更します。ボリュームサイズ、IOPS、およびスループットに新しい値を入力します。 |

問題 2 の説明および補足

gp2 から gp3 に移行する

ボリュームタイプの変更 は、運用上のオーバーヘッドを最小限に抑えながら、Amazon EC2 インスタンスの中断なく Amazon EBS ストレージを gp2 から gp3 にアップグレードできるため正解です。ボリュームタイプ の変更は、Amazon EBS コンソール、AWS Command Line Interface (AWS CLI)、または AWS Software Development Kit (SDK) を使用して簡単に行えます。これにより、ボリュームサイズ、IOPS 、および スループット の新しい値を指定することにより、必要に応じてストレージのパフォーマンスを最適化できます。

問題3 |

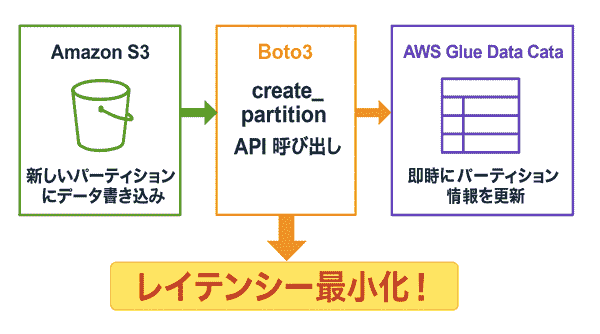

企業は、データレイクに使用する Amazon S3 ストレージをパーティション (分割) する必要があります。パーティションでは、s3://bucket/prefix/year=2023/month=01/day=01 形式の S3 オブジェクトキーのパスが使用されます。

データエンジニアは、企業がバケットに新しいパーティションを追加するときに、AWS Glue Data Catalog が S3 ストレージと同期することを保証する必要があります。

これらの要件を最も少ないレイテンシーで満たすソリューションを選択してください。

AWS Glue CreatePartition API を毎日 2 回手動で実行します。 | |

AWS Glue コンソールから MSCK REPAIR TABLE コマンドを実行します。 | |

AWS Glue クローラーを毎朝実行するようにスケジュールします。 | |

Amazon S3 にデータを書き込むコードを使用して、Boto3 AWS Glue create_partition API 呼び出しを呼び出します。 |

問題 3 の説明および補足

AWS Glue API の呼び出し

Amazon S3 にデータを書き込む際に Boto3 AWS Gluecreate_partition API を呼び出すことで、AWS Glue Data Catalog が S3 ストレージと即時に同期できます。これにより、データエンジニアは新しいパーティションが追加されるたびに手動で介入することなく、AWS Glue Data Catalog が常に最新の状態を保つことを保証できます。この方法は、レイテンシーを最小限 に抑えることができます。

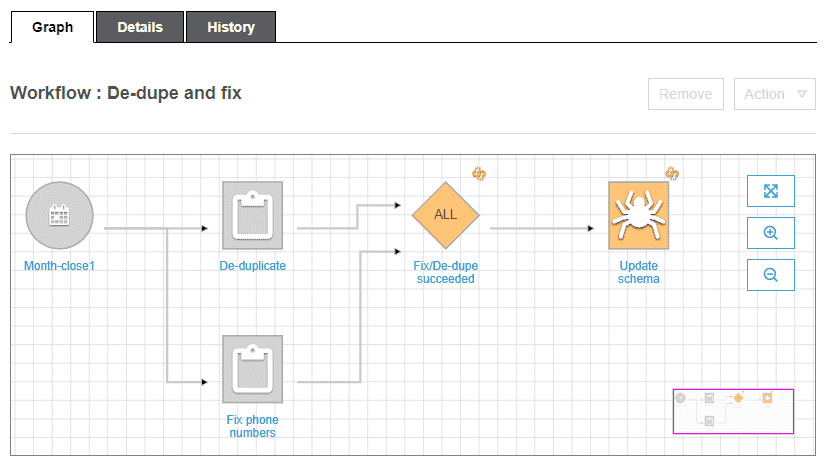

問題4 |

ある企業は、AWS Glue で ETL (抽出、変換、ロード) データパイプラインを作成しました。データエンジニアは、Microsoft SQL Server のテーブルをクロールする必要があります。データエンジニアは、クロールの出力を抽出、変換し、Amazon S3 バケットにロードする必要があります。データエンジニアは、データパイプラインを調整する必要もあります。

これらの要件を最もコスト効率よく満たす AWS のサービスまたは機能を選択してください。

AWS Glue Studio | |

AWS Glue ワークフロー | |

AWS Step Functions | |

Amazon Managed Workflows for Apache Airflow (Amazon MWAA) |

問題 4 の説明および補足

AWS Glue ワークフロー

「AWS Glue ワークフロー」 を使用することで、Microsoft SQL Server のテーブルのクロール、抽出、変換、Amazon S3 へのロードを一元管理し、最もコスト効率が良いため正解です。

問題5 |

ある企業は、RA3 ノードで稼働する Amazon Redshift クラスターを使用しています。同社は、需要に合わせて読み取りと書き込みのキャパシティを拡張したいと考えています。データエンジニアは、同時実行スケーリングを有効にするソリューションを特定する必要があります。

この要件を満たすソリューションを選択してください。

Redshift Serverless ワークグループのワークロード管理 (WLM) で同時実行スケーリングを有効にします。 | |

Redshift クラスターのワークロード管理 (WLM) のキューレベルで同時実行スケーリングを有効にします。 | |

Redshift クラスターの 1 日あたりの使用量クォータの同時実行スケーリングを有効にします。 | |

新しい Redshift クラスターを作成する際の設定で、同時実行スケーリングを有効にします。 |

問題 5 の説明および補足

同時実行スケーリングを使用する

「同時実行スケーリング」 を有効にすることで 読み取りと書き込みのキャパシティを動的に拡張 できるため正解です。問題6 |

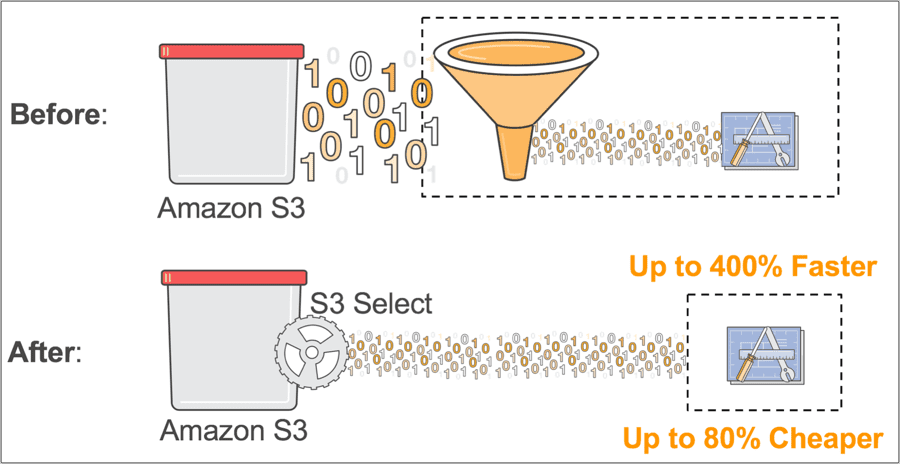

データエンジニアは、Amazon S3 バケットにある Apache Parquet 形式のオブジェクトからデータを読み取る 1 回限りのタスクがあります。データエンジニアは、データの 1 つの列のみをクエリする必要があります。

運用上のオーバーヘッドを最小限に抑えながら、これらの要件を満たすソリューションを選択してください。

S3 Select を使用して SQL SELECT ステートメントを作成し、S3 オブジェクトから必要な列を取得します。 | |

S3 オブジェクトで AWS Glue クローラーを実行します。Amazon Athena で SQL SELECT ステートメントを使用して、必要な列をクエリします。 | |

S3 オブジェクトを使用し、必要な列をクエリするために AWS Glue DataBrew プロジェクトを準備します。 | |

AWS Lambda 関数を構成して、S3 バケットから pandas データフレームにデータをロードします。必要な列をクエリするために、データフレームに SQL SELECT ステートメントを記述します。 |

問題 6 の説明および補足

S3 Select

「Amazon S3 Select」 は、オブジェクトストレージ内のデータから特定のデータのみを効率的に取得する機能を提供します。このサービスを使用することで、Amazon S3 に格納されている Apache Parquet 形式のデータから、特定の列のみを直接クエリできます。S3 Select を利用することで、全体のデータセットをダウンロードし処理する代わりに、必要なデータのみを抽出できるため、実行時間とコストを大幅に削減できます。 ※Amazon S3 Select を使用して、サーバーまたはデータベースなしでデータをクエリする 以前は、データをクエリするにはデータベースにロードする必要がありました。データベースのデプロイに加えて、顧客は検索を有効にするためにアプリケーションとウェブサイトをデプロイする必要があります。データベースと関連リソースをデプロイする代わりに、S3 Select と呼ばれる S3 機能を利用して、完全にサーバーレスな電話帳検索ツールを作成します。 参考URL : Amazon S3 Select を使用して、サーバーまたはデータベースなしでデータをクエリする ※Amazon S3 Select を使用したデータのフィルタリングと取得 Amazon S3 Select を使用してこのデータをフィルタリングする場合、Amazon S3 が転送するデータの量を抑えることで、このデータの取得に必要なコストを削減し、レイテンシーを抑えることができます。 Amazon S3 Select は、CSV、JSON、または Apache Parquet 形式で保存されたオブジェクトを操作します。また、GZIP や BZIP2 で圧縮されたオブジェクト (CSV と JSON 形式のオブジェクトのみ) や、サーバー側で暗号化されたオブジェクトにも使用できます。結果の形式 (CSV または JSON) や、結果のレコードを区切る方法は指定できます。 参考URL : Amazon S3 Select を使用したデータのフィルタリングと取得 ※(引用) Amazon S3 Select S3 バケット内に保存したオブジェクトに対し、SQL 文を用いてデータの一部分のみを取り出すことができるサービスです。アプリケーションが必要なデータのみ取得ができるので、パフォーマンスの向上が期待できます。

問題7 |

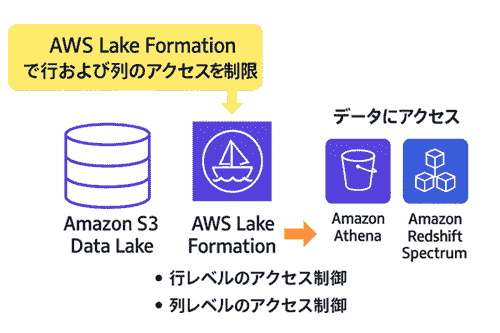

企業は AWS にデータレイクを構築する必要があります。企業は、行レベルのデータアクセスと列レベルのデータアクセスを特定のチームに提供する必要があります。チームは、Amazon Athena、Amazon Redshift Spectrum、および Amazon EMR からの Apache Hive を使用してデータにアクセスします。

運用上のオーバーヘッドを最小限に抑えながら、これらの要件を満たすソリューションを選択してください。

データレイクのストレージに Amazon S3 を使用します。Amazon EMR 経由で Apache Ranger を使用して、行と列でデータアクセスを制限します。Apache Pig を使用してデータアクセスを提供します。 | |

データレイクのストレージに Amazon S3 を使用します。AWS Lake Formation を使用して、行と列でデータアクセスを制限します。AWS Lake Formation 経由でデータアクセスを提供します。 | |

データレイクのストレージに Amazon S3 を使用します。S3 アクセスポリシーを使用して、行と列でデータアクセスを制限します。Amazon S3 経由でデータアクセスを提供します。 | |

データレイクのストレージに Amazon Redshift を使用します。Redshift セキュリティポリシーを使用して、行と列でデータアクセスを制限します。Apache Spark と Amazon Athena フェデレーテッドクエリを使用してデータアクセスを提供します。 |

問題 7 の説明および補足

Lake Formation での行レベルのアクセスコントロールによるデータレイクの保護

「AWS Lake Formation」 を使用して行と列のデータアクセスを制限することで、要件を満たしながら運用上のオーバーヘッドを最小限に抑えることができるため正解です。

問題は全部で 7 問。全て答えられるように頑張りましょう!

|

リスト |